666Kamikadze666

Понравилось? Ставьте +_ик в репу, а то меня — супер-пупер-модера — уже догоняют...

| Radeon.ru https://forum.radeon.ru/ |

|

| Флейм из ATI vs NVIDIA https://forum.radeon.ru/viewtopic.php?f=14&t=47092 |

Страница 1 из 1 |

| Автор: | U-Nick [ 18:23 22.12.2014 ] |

| Заголовок сообщения: | Флейм из ATI vs NVIDIA |

666Kamikadze666 Понравилось? Ставьте +_ик в репу, а то меня — супер-пупер-модера — уже догоняют...

|

|

| Автор: | MikeIS [ 19:05 22.12.2014 ] |

| Заголовок сообщения: | |

U-Nick Флейм не котируется

|

|

| Автор: | Asmodeus [ 22:17 22.12.2014 ] |

| Заголовок сообщения: | |

MikeIS Явно зря. Иногда здесь полезной информации больше чем в профильных ветках. |

|

| Автор: | - frontier - [ 09:38 23.12.2014 ] |

| Заголовок сообщения: | |

U-Nick А кто вас догоняет? Давайте мы забаним этого человека!

|

|

| Автор: | 666Kamikadze666 [ 12:22 23.12.2014 ] |

| Заголовок сообщения: | Re: |

так Вы посмотрите репу повнимательнее  . пришлось правда по форуму полазить, чтобы плюсануть. тут же нельзя... . пришлось правда по форуму полазить, чтобы плюсануть. тут же нельзя...

|

|

| Автор: | U-Nick [ 15:46 23.12.2014 ] |

| Заголовок сообщения: | |

давайте ПОДДЕРЖИМ этого человека! давайте ПОДДЕРЖИМ этого человека!Ребятки, ну вы что, совсем шуток не чуете?  666Kamikadze666 Ага, уже увидел...

|

|

| Автор: | - frontier - [ 19:27 23.12.2014 ] |

| Заголовок сообщения: | |

U-Nick

Понимаем. Поэтому и шутим в ответ. :) А если серьёзнее, скоро Новый Год, в т.ч. на форуме, вы готовы? Дело это добровольно-принудительное.  Думаю, Деду Морозу плюсов поставят прилично. -- Добавлено спустя 3 ч 10 мин 32 с -- U-Nick Вот теперь другое дело!!!  Поздравляю!!!!! |

|

| Автор: | 666Kamikadze666 [ 08:12 24.12.2014 ] |

| Заголовок сообщения: | Re: |

Да кстати, снежинки будут?

|

|

| Автор: | U-Nick [ 12:37 24.12.2014 ] |

| Заголовок сообщения: | |

Ну вот, опять меня запрягли...  Но это — ПОСЛЕДНИЙ РАЗ! Но это — ПОСЛЕДНИЙ РАЗ!  В следующем году я уже выйду из дед-возраста... на следующую ступеньку В следующем году я уже выйду из дед-возраста... на следующую ступеньку  666Kamikadze666 А вот даже я не в курсе...  Эх, вот был бы классный подарок всем нам — вставка картинок прямо с наших компов Эх, вот был бы классный подарок всем нам — вставка картинок прямо с наших компов

|

|

| Автор: | - frontier - [ 15:27 25.12.2014 ] |

| Заголовок сообщения: | |

666Kamikadze666

Вероятно. |

|

| Автор: | ev23 [ 15:57 12.01.2015 ] |

| Заголовок сообщения: | |

сюда еще пост вставлю) стояла раньше зеленая, теперь поставил красную на эту же систему. в программах установленных осталась PHYSX, но нужна ли она теперь или можно эту прогармму удалять смело.ну и всё, что с ней связано? |

|

| Автор: | Katiphus [ 19:45 12.01.2015 ] |

| Заголовок сообщения: | |

ev23 Не будут работать игры где физический движок — PhysX. |

|

| Автор: | Asmodeus [ 22:34 12.01.2015 ] |

| Заголовок сообщения: | |

А вот кстати — вопрос. Раньше, когда ставил на Windows 8 драйвера видеокарты nvidia, то устанавливались отдельно и драйвера физикса — их было видно в программах и компонентах. Раньше я их удалял вместе с основными драйверами nvidia перед установкой новых дров. А теперь — последние 2-3 версии официальных драйверов nvidia — драйвера физикса в программах и компонентах вообще не отображаются, хотя нвидиевский установщик показывает, что драйвера физикса установлены  Это теперь у nvidia фича такая, что отдельно драйвера физикса нельзя снести через меню программы и компоненты?

|

|

| Автор: | Жёсткий_Чебур [ 11:31 14.01.2015 ] |

| Заголовок сообщения: | |

Asmodeus Отображается. В крайнем случае сносите через установщик. |

|

| Автор: | DigiMakc [ 15:29 24.01.2015 ] |

| Заголовок сообщения: | |

Видеокарты GeForce GTX 970 не могут работать с 4 ГБ памяти эффективным образом

|

|

| Автор: | Жёсткий_Чебур [ 16:11 24.01.2015 ] |

| Заголовок сообщения: | |

Так правильнее

|

|

| Автор: | DigiMakc [ 16:14 24.01.2015 ] |

| Заголовок сообщения: | |

Жёсткий_Чебур У меня не 290х, но когда был синий экран в последний раз уже и не помню.

|

|

| Автор: | S_U [ 16:44 24.01.2015 ] |

| Заголовок сообщения: | |

DigiMakc Тоже самое, у меня и на 290x их небыло. Система молотит сутки на пролет и ничего. Минус 290x только в шумности и горячести стандартной со, а так она даже досих пор обходит 980 кое где и особенно в 4k. |

|

| Автор: | DigiMakc [ 04:05 25.01.2015 ] |

| Заголовок сообщения: | |

nVidia GTX 970 above and below 3.5GB usage video capture Вроде как есть информация, что 660, 660Ти 192, 770 тоже этим страдают. http://www.pcper.com/news/Graphics-Card ... mory-Issue NVIDIA GeForce GTX 970 не может использовать все 4 ГБ видеопамяти |

|

| Автор: | Жёсткий_Чебур [ 09:51 25.01.2015 ] |

| Заголовок сообщения: | |

Очень интересный комментарий с Оверов: http://forums.overclockers.ru/viewtopic.php?p=12628254#p12628254 |

|

| Автор: | DigiMakc [ 13:38 25.01.2015 ] |

| Заголовок сообщения: | |

Жёсткий_Чебур Видел. Как проверить? Тоже писали на форуме: Переключаемся на встроенную видюху intel, и подключаем к ней монитор. А nVidia тестируем. |

|

| Автор: | Walter S. Farrell [ 19:37 25.01.2015 ] |

| Заголовок сообщения: | |

NVIDIA = перманентный "синяк" на 32-битном Windows 2003 Server (The driver is mismanaging system PTEs). Они в курсе уже который год, но исправлять не хотят и не будут. Даже из списка загрузки убрали, а на все вопли поддержка стандартно предлагает дрова от XP, которые не работают и они это знают, или посылают на фиг к ОЕМам. 64-битный 2003 Server как бы поддерживается, но более-менее нормально работает только в 2D, иначе валится в тот же "синяк". Так что сказки о качестве дров NVIDIA можно оставить фанатам, они всё стерпят. Качество железа NVIDIA тоже не вызывает восхищения. Они даже в бивисы зашивают критическую температуру целых 110 градусов, поэтому через пару лет работы видяхи часто дохнут (ничего, пусть юзеры новые покупают). Поднимаются хреново, 75% уходит в разборку. Вчера жарил 7 дохлых и полудохлых карт, в том числе 6 NVIDIA от 7900GTX до 9800GX2. Одна осталась с теми же артефактами, остальные совсем трупы с внутричиповым КЗ или без признаков жизни. 7-я была HD5970 с отвалом основного камня, поднялась без проблем. |

|

| Автор: | Katiphus [ 23:08 26.01.2015 ] |

| Заголовок сообщения: | |

Хуанговская инженерия в действии. Walter S. Farrell

У Радеонов такая же, если не больше. Лично у меня 6950 разлоченный хреначил 105 градусов и ничего. |

|

| Автор: | DigiMakc [ 23:39 26.01.2015 ] |

| Заголовок сообщения: | |

На английском: http://www.pcper.com/reviews/Graphics-C ... ns-GTX-970 Это пипец  NVIDIA GeForce GTX 970 в деталях: 56 RBE и урезаный кеш |

|

| Автор: | Жёсткий_Чебур [ 16:35 27.01.2015 ] |

| Заголовок сообщения: | |

На соседнем ресурсе выложили тест скорости памяти для всех видеокарт: Тест скорости видеопамяти. Теперь испытать батхёрт сможет каждый.

|

|

| Автор: | msivano [ 18:00 27.01.2015 ] |

| Заголовок сообщения: | |

Мой репост по этому поводу из соседнего флейма. Проблема раздутая на пустом месте и не стоящая и выеденного яйца. Память все равно вся доступна, только приоритет отдан первому банку из 3,5 гигов, а если там не поместится подключится еще 0,5 гига памяти. Падение производительности при этом равно статистической погрешности, но чтобы раздуть скандал используют такие большие проценты  В реале — дает игра 100 кадров, ну а могла бы 102 или иногда 105 давать, или к примеру выдает 60 кадров ( а игры стараются под это значение лочить ) — ну выдала бы 60,6 кадра. Короче очередной вброс черного пиара, раздутого из блохи до уровня индийского слона. Лучше прикиньте разницу в цене. Этим все объясняется, а то многие хотя купить 970 и чтоб она была как 980, тогда на кой эту 980 было бы выпускать. А пускать на 970 и карты более младшие полноценный чип и разводку всех компонентов, а затем это дело отключать блоками, дабы разграничить по производительности, это уже дебилизм. Прошли времена разлочки карт, пора бы это уже давно принять и не засирать флеймы раз от разу, не разобравшись даже в причинах, вынудивших так поступить команду инженеров. |

|

| Автор: | SevenXP [ 19:55 27.01.2015 ] |

| Заголовок сообщения: | |

msivano Не не 2-5% это слишком много. Ура NVIDIA ГЭ

|

|

| Автор: | Katiphus [ 19:59 27.01.2015 ] |

| Заголовок сообщения: | |

msivano

Хорошо хорошо, 2 банк памяти не дает занижение производительности... или дает? Не суть, все это не столько важно, сколько ложь про ROP, КЭШ и VRAM GTX970. |

|

| Автор: | DigiMakc [ 20:51 27.01.2015 ] |

| Заголовок сообщения: | |

Жёсткий_Чебур Дело даже не в тесте, к тесту тоже есть вопросы, и они подняты на форуме  Конкретно если говорить о 970, то выяснились интересные детали, которые многих оттолкнут от выбора этой карты. Т.е. по заявлению производителя — одно, а на деле, как выясняется, — другое. Но есть подозрение, что это не конец истории

|

|

| Автор: | SevenXP [ 21:54 27.01.2015 ] |

| Заголовок сообщения: | |

DigiMakc +1 вот я теперь вообще не буду брать 970, зачем мне то, что специально было урезанно и они об этом знали. Тогда надо было делать не 4 гб а 3.5гб, это было бы честно. А так я считаю, что я даром заплачу за 512 мб |

|

| Автор: | msivano [ 04:43 28.01.2015 ] |

| Заголовок сообщения: | |

DigiMakc SevenXP Что бы оперировать такими заявлениями:

Нужно как минимум обладать хоть какими то доказательствами, а чтобы их получить, нужно выпустить аналогичную 970 лишенную этих недочетов, что на текущем варианте архитектуры максвел не возможно. Если сравнивать ее с полноценным чипом 980, то вариант чипа 970 соответствует заявленному уровню производительности и той нише на которую он нацелен.

У вас чем то подтвержденные данные, что те 512 метров памяти распаянных на плате играм не доступны, или вы утверждаете что их там нет, либо, что эти 512 метров вообще не работают??? Пардон, но вы явно заблуждаетесь, так как память доступна вся.

По этому параметру да, есть обоснованные претензии. Но отсутствие нескольких заявленных блоков растеризации и отсутсвие 256 килов кеша вызвало у карты какие либо технические сбои, фризы на ровном месте, обоснованно доказанное падение производительности выше того порога, указанного в инженерной спецификации, либо не функциональность второго блока памяти? Ответ нет.

В чем ложь??? Памяти 4 гб установленно? — 4, доступно все 4 гб? — доступно, используется ли все 4 гб по своему назначению? — используется. Повторюсь — в чем ложь??? Вы наверное считаете, что если игре допустим чтобы обработать графику на текущем разрешении достаточно 3гб памяти и подключив четвертый гиг вы получите прирост??? Если игре нужно 3 гига в текущий момент, она и будет есть 3 гига, выдавая то что выдают блоки растеризации и текстурирования ( именно их производительность в купе с поддержкой определенных инструкций и расширений графических движков) и дает вам фпс, а не одна лишь память. Другое дело если игре нужно к примеру памяти больше, чем у вас есть, тогда да, добавив еще памяти вы получите прирост, правда до тех пор, пока хватает производительности блоков растеризации и текстурирования, но а до тех пор толка не будет. И конечно немаловажно каким образом оно доступно, но если бы прежде чем начинать холивар вы поинтересовались прошлым картостороения, то могли бы заметить, что память раньше паяли банками разной плотности и объема( и о чудо, раньше, чтобы получить к примеру гиг памяти, приходилось его набирать из памяти разной плотности, а она сволочь имела разное количество контактных точек для припайки, и что немаловажно чип имел, да и сейчас имеет, ограниченное количество линий, на которые можно припаять эти чипы,набирать память плотными банками — невыгодно, так как дорого и неизбежно получится переизбыток памяти ( дружно вспоминаем карты от нв с забавным количеством памяти — 896, 1392, 1768 мегабайт ) , дабы получить нужный объем памяти, потому как распаять на подводах к ядру можно лишь определенный объем, а не то, сколь заблагорассудится. Но делав так, производительность проседала от теоретической куда более ( не поленитесь, найдете старые холивары по этому поводу в инете), нежели решение, которое применило в этот раз нв. Нв распаяла чипы одинакового объема и плотности, разграничив адресное пространство лишь за счет приоритизации доступа, первых три с половиной гига доступны сходу всему, а дополнительные пол гига только если не хватило места в основном массиве, что в свою очередь повлекло падение производительности в пределах 2 — 5% и то лишь тогда, когда используется больше чем три с половиной гига памяти, а до тех пор карта будет выдавать все, на что способна, в полной мере. Что имеем в сухом остатке: 1) Используются ли все 4 гигабайта памяти? — ответ используются. 2) Стоит ли наказать пиар-отдел за недостоверную информацию касательно блоков растеризации и кеша? — однозначно стоит. 3) Удалось ли инженерам максимально достойно компенсировать недостаток блоков и недостающие 256 килов кеша, сохранив при этом общую производительность в допустимых пределах ? — удалось, пока не будет объективно доказано обратное, с конкретными примерами. 4) Стоит ли тем, кто купил эти карты не зная этого, бежать и сдавать их в магазин, меняя на аналоги либо старший чип? — только если их не устраивает производительность, коей поверьте хватает с избытком. 5) Соответствует ли GTX970 той плоскости рынка, на который она была нацелена? — соответствует. 6) Стоит ли нв скинуть немного цену в качестве извинений? — однозначно да, что и будет скорее всего сделано. P.S. Но уж если на то пошло, то пусть реально супер-пупер быстрой памяти в карте 3,5Гб, а остальные 500мб грубо говоря "медленнее", Хорошо, но вы когда карту выбираете, берете ту у которой памяти больше или шина шире, а не ту которая вам по карману и обладает достаточной вам производительностью? По тестам прекрасно видно разницу между 980-й и 970-й и эта разница была искусственно, с помощью отключения части вычислительных блоков, создана, для того что бы разделить две карты по разным сегментам и назначить им соответствующие цены. Ну так вот и скажите мне, если бы у 970-й была "идеально" быстрая 4Гб оперативка и она была бы быстрее процента на 2-5 как тут заявляется, что бы помешало нвидии, слегка понизить частоту памяти/чипа что бы эти самые 2-5% убрать и не соревноваться с топовым сегментом или новыми карами (какой-нибудь 970Ti к примеру)? Нет, есть конечно люди принципиальные, которые скажут, мол умолчали, скрыли, обманули и т.д. Хорошо, вы правы, но тогда и не только нвидию нужно четвертовать, а начать хотя бы с производителей жестких дисков, что уже не один десяток лет считают гигабайт как 1000мб и производителей экранов заодно что измеряют быстродействие матрицы в идеальных, оторванных от реальности, условиях. Таких примеров — вагон и еще столько же будет. |

|

| Автор: | Katiphus [ 08:06 28.01.2015 ] |

| Заголовок сообщения: | |

msivano

Нет, я знаю для чего нужна видеопамяти и прирост будет от дополнительной VRAM только тогда, когда VRAM будет уже мало на столько, что оставшиеся текстуры будут забиваться в ОЗУ. Вы можете провести опрос и поймете что есть люди, а их не мало, кто купил GTX970/980 только из-за 4ГБ видеопамяти.

Когда я выбираю карту я смотрю на производительность и цену. В конце концов я что зря что ли купил R9 290X PCS+ за 4000 рублей когда тот 30к стоил, а щас все 40? |

|

| Автор: | msivano [ 08:35 28.01.2015 ] |

| Заголовок сообщения: | |

Katiphus Я когда карту покупаю, смотрю чтобы было адекватное соотношение цена/качество/нормальные дрова — нв вне конкуренции, во всяком случае пока.

О чем я и написал ниже выделенного вами куска поста, приведенного для цитаты.

Нет, не зря, но он у вас нормально работать не захотел, причина этого в том что амд давно пора было выпустить набор обновленной системной логики для их продуктов, с гарантированной поддержкой последнего их оборудования, дабы не заводить его танцами с бубном. Должно быть как — есть платформа, для нее выпускают железо и производитель говорит что оно совместимо и будет работать нормально, из этого железа я собрал себе стацик — он должен завестись и работать так, чтобы у меня голова не болела по принципу — включил, загрузился, пользуйся. А не так, что купил, собрал, поставил ось и понеслась кривая в кось, пока кто нибудь не выложит решение проблемы, которое может помочь, а может и не помочь. В этом плане я за нв спокоен. Как пример — есть комп, собранный еще на 754 сокете, биос не перепрошивался с момента покупки, на него была поставлена сначала HD4850, которая отпахала как часы. Затем спустя 5 лет она издохла и была приобретена hd6850 — не стартанула, 7770 — тоже самое, клиент плюнул и купил 650ти — завелась с пол оборота и нормально работает. |

|

| Автор: | Katiphus [ 08:58 28.01.2015 ] |

| Заголовок сообщения: | |

msivano

Проблема не в нем. И не в софте.

Есть комп, стоит в деревне с процом уровня Атлон x64 3200+ и Radeon 2600XT и без проблем все работает а ему уже больше 10 лет. Что-то не так? -- Добавлено спустя 6 мин 22 с --

Советую вам посмотреть на ламели разьема видеокарт. Может так будет понятнее что у 650Ti их в разы меньше и скорее всего от суда надо плясать. |

|

| Автор: | msivano [ 09:16 28.01.2015 ] |

| Заголовок сообщения: | |

Katiphus

Сравни как минимум давность железа  Год выпуска 2600xt и 650ти. А затем возьми 290 и вставь туда, как думаешь заведется? и о чем это говорит?? — все началось с того что амд перешла на GCN и вот тогда эти танцы с бубном и начались — проследи тенденцию возникновения проблемы Год выпуска 2600xt и 650ти. А затем возьми 290 и вставь туда, как думаешь заведется? и о чем это говорит?? — все началось с того что амд перешла на GCN и вот тогда эти танцы с бубном и начались — проследи тенденцию возникновения проблемы  Или вы хотите сказать, что ваша 970 от того что вы узнали правду как она есть стала хуже работать и превратилась в 5200титаниум? — как тянула так и тянет. У друга на его 970+ 4590 4 фаркрай выдает до 105 фпс, а видео лучше писать афтебернером — меньше (значительно ) ресурсов потребляет. |

|

| Автор: | Katiphus [ 09:17 28.01.2015 ] |

| Заголовок сообщения: | |

msivano

Заведется, а потом мать сгорит потому что вряд ли рассчитана на потребление в 350Вт по линии PCI-E.

У меня после GCN (первая видеокарта была 5850) проблем как раз стало меньше. Это вторая проблема с AMD за все это время (и то причем тут видеокарта? ну допустим виновата AMD с ее GCN а не материнская плата и южный мостик). Первая кстати заклюачалась в драйвере, номер не помню но вроде 14.2 или 14.4 при удалении которого сносились драйвера чипсета и usb-хост контроллера причем как на платформе Intel так и на AMD, при запуске системы отключались все USB, работал только PS/2 и решить проблему можно было только точкой восстановления или переустановкой системы (хотя может быть можно было и как-то еще). А так за время использования 5850, 6870, 6950, 7870 PCS+, 7950, 7970, r9 290x, кросс-сборок вроде 7950+7870 PCS+ или 7950+7970 ни каких проблем не было, у отца на 7870 тоже все пучком, а ныне на моем прошлом 7970 все без проблем. Не понимаю людей которым просто не повезло с 1 картой AMD ныть про кривизну драйверов и якобы низкую производительность в сравнении с nVidia. Зато с GTX560Ti проблемы были, хоть и не значительно но тем не менее: с одним драйвером в БФ3 текстуры плывут (очень распространенная проблема была на этой карте в этой игре), с другим троттлинг не работает, с третьим производительность меньше. Хотя в остальном хорошо отработала и производительность не плохая. |

|

| Автор: | msivano [ 09:22 28.01.2015 ] |

| Заголовок сообщения: | |

Katiphus

Запитай от своего блока, в чем проблема. А мамке ничего не будет — PCI-E — разных версий обратносовместим и доп питание возмет от блока и от слота свои 75 ватт. -- Добавлено спустя 6 мин 4 с -- Katiphus Все модели до HD 76xx основаны на архитектуре VLIW5, модели HD 77xx-79xx основаны на архитектуре Graphics Core Next. Ну и более старшие естественно. |

|

| Автор: | Katiphus [ 09:31 28.01.2015 ] |

| Заголовок сообщения: | |

Не знал, думал что GCN с тех пор как DX11 появился. Но все равно 5 разных карт и кросс-сборки, а проблем нет. |

|

| Автор: | msivano [ 09:37 28.01.2015 ] |

| Заголовок сообщения: | |

Katiphus Проблемы на которые жалуются, касаются отнюдь не игр. Первое это кривое аппаратное ускорение, которое часто приходится отключать иначе синька при просмотре потокового видео на ютьюбе считай обеспечена ( до сих пор не вылечена ). У нв когда крашится это дело просто плагин выбивает, перезапуск браузера обычно помогает. Вторая проблема на которую жалуются это дрова. У нв тоже бывают дрова косячные — когда семерка вышла, то с версии 314 прошло 6 выпусков дров, пока на моей 460 тогда была нормальная производительность и все норм заработало, на более старой версии дров все работало четко. Причем на старых картах ускорение (до HD5ххх включительно ) работает исправно. |

|

| Автор: | Katiphus [ 09:48 28.01.2015 ] |

| Заголовок сообщения: | |

Я бы рад попробовать топ уровня 780Ti, но никто не предлагает его за 4000. Зато артефачные 560-580 продают за 500-1000 рублей, бери — не хочу, а решение артефактов, как вы понимаете, дело минутное, когда есть технический фен или газовая горелка

|

|

| Автор: | msivano [ 09:51 28.01.2015 ] |

| Заголовок сообщения: | |

Katiphus Кто же ее предложит за такие деньги — если только дохлую... |

|

| Автор: | Katiphus [ 10:01 28.01.2015 ] |

| Заголовок сообщения: | |

Но 290Х предложили же. На момент актуальности 500 серии кое-кто продавал 560Ti на гарантии даже не распакованную за 2300 рублей, я ее потом за 4к загнал. |

|

| Автор: | msivano [ 10:16 28.01.2015 ] |

| Заголовок сообщения: | |

Katiphus Повезло  Я свою 680 выиграл. Теперь вот жду то, что будет за 9 серией. Там такое нв удумало, что аж слюнки текут. |

|

| Автор: | Жёсткий_Чебур [ 10:26 28.01.2015 ] |

| Заголовок сообщения: | |

Так все косяки уже заложены в стоимость карты. Сейчас 980 лежат по ~37 кило₽, причём в ассортименте, а 970 по ~22 кило₽ и поди ещё найди — расхватали всё. Разница в 15 тысяч. Где вы тут переплачиваете за пол гига? Это вы в 980-й доплачиваете стоимость не соразмерную увеличению производительности. Апгрейд сегодня выглядит так: • Прицениваемся к 980-й. • Добавляем стоимость хорошего водоблока (фуллкавер). • ВНЕЗАПНО собираем SLI из 970.  • ?????  • PROFIT  Если нужна вода, карты отлично охлаждаются универсальными ВБ, коих в Китае валом. Для эстетов есть и фуллкаверы.

Хорошо расписали.

|

|

| Автор: | msivano [ 10:30 28.01.2015 ] |

| Заголовок сообщения: | |

Жёсткий_Чебур Да оно и на воздухе очень тихая, а в 2д так вообще куллера стоят. |

|

| Автор: | Katiphus [ 11:05 28.01.2015 ] |

| Заголовок сообщения: | |

Мне кажется можно найти дешевый GTX780Ti которая на одинаковых частотах еще и с 980ой потягаться может. Например этот вариант, да на чип не 1Ггц, но думаю она легко его возьмет. |

|

| Автор: | DigiMakc [ 14:01 28.01.2015 ] |

| Заголовок сообщения: | |

Если выпустить видёху без указанных недочётов, то это будет как раз GTX 980  Память то доступна, но поделена на 2 сегмента, один из которых имеет скорость в 7 раз меньше  Об этом раньше не было заявлено производителем. Когда пользователь покупает железо, он то думает что вся память работает как надо, а не через одно место, как у 970. Об этом раньше не было заявлено производителем. Когда пользователь покупает железо, он то думает что вся память работает как надо, а не через одно место, как у 970.Дело не в производительности, а в факте, что заявленные характеристики не соответствуют действительности. Стоит, потому что товар не соответствует заявленным характеристикам. Не сгорит, потому что карта питается доп.питанием. Вообще-то Radeon 5000 основан на VLIW5, а R.. 6000 на VLIW4. Ну меня 7850 и что? Всё работает, ничего не глючит. -- Добавлено спустя 22 мин 20 с -- Подскажите ка, как мне этот самый глук словить? Что мне нужно для этого сделать ?

|

|

| Автор: | msivano [ 14:35 28.01.2015 ] |

| Заголовок сообщения: | |

DigiMakc Мне ток интересно, чем автор той статьи замерял скорость той памяти. Если бы она работала в 7 раз медленнее, то потеря производительности в сводной диаграмме на которую ссылается автор была бы куда как больше, чем 2 — 5%, которые в итоге и намерили местами. -- Добавлено спустя 12 мин 53 с -- DigiMakc Это мне напоминает анекдот советских времен: консилиум хирургов — выступает американец — вот мы провели операцию нашему пациенту, он слепой был от рождения, так мы ему деревянные глаза пересадили! Теперь он видит как все!!! — Аудитория — Браво, поздравляем!!!— это же прорыв!!! — Тут русские думают, чем бы то так ответить??? — Встает значит наш и начинает рассказ — Значит давеча попал к нам пациент, когда он косил сено, то устал и прилег в траве отдохнуть на бережку. На ту беду там девахи местные купались. Он это дело увидал и у него встал, а трава высокая, его не видно. Тут его друг окашивая берег ему хозяйство то под самый корень и того... Ну мы думали что делать и в итоге пересадили ему вымя!!! — теперь он с утра и по доится успевает, и баб четверых за раз обслужить! — встает американец — Все это есть большой Русский пиздешь! — какие ваши доказательства! — кто это видел!!! — русский ему и отвечает — да вот ваш хер, с деревянными глазами и видел. И дабы прекратить бесполезный холивар вот Пруфф на оригинал статьи. Как видите ни слова о 1/7 скорости работы нет, есть только сводная диаграмма на примере разницы 980/970 где и видна потеря в 2 — 5% от теоретического максимума 970 без данной сегментации памяти. С таким успехом можно нести и сдавать обратно все вени с компа, ведь там не 2 тб а 1,81 — не 3тб, а 2,72 — деньги берут как за три.И вот на этот обман ( как пример ) глаза закрывают и гордо говорят я купил 3 тб вень, а не 2,72. И таких примеров на целый состав наберется. -- Добавлено спустя 49 мин 10 с --

Включить аппаратное ускорение в флеш плеере и смотреть потоковое видео. Многие ловят, о чем свидетельствует тот срач на офф сапорте адобе и амд, а так же неоднократно возникающие темы на форумах в частности (наш не исключение). P.S. Движок форума что ли барахлит?

Хотя прошло от силы 4 минуты??? |

|

| Автор: | DigiMakc [ 15:36 28.01.2015 ] |

| Заголовок сообщения: | |

Ну игрухи то грузят память не полностью, и приоритет отдаётся основрому разделу, который 3,5 ГБ. А этот пруф Вам не нравится? http://www.pcper.com/reviews/Graphics-C ... ns-GTX-970 И тут всё по полочкам раскладывается. Ну это уже давно так, и пользователи в общем-то знают, что памяти всегда меньше чем пишется. К тому же, производители, например WD указывает кол-во LBA, по которому можно посчитать реальную ёмкость.  312581808 LBA * 512 Б/сектор = 160041885696 / 1024 /1024 / 1024 = 149.0506210327148 ГБайт. А то, что Seagate не пишет на своих дисках подобной инфы — чести им не делает. На фуфло-дисках — фуфло-информация, всё сходится  А в данном случае с видеокартой. Кто знал, что память двухсегментаня и что РОПов с кэшем меньше? Например? -- Добавлено спустя 4 мин 49 с -- у меня там HTML5 плеер, я без понятия пользуется он аппаратным ускорением или нет  Но БСОДов нет. Но БСОДов нет.Переключился на flash, аппаратное ускорение включено. Не БСОДит что-то. Но с этим плеером 4k и 60FPS не воспроизводятся, а с HTML5 всё пашет. |

|

| Автор: | Walter S. Farrell [ 15:52 28.01.2015 ] |

| Заголовок сообщения: | Re: |

Это проблема в совместимости новых карт с PCI Express 1.0 северниками былых времён. Например, в моей древней Abit AT8 32X на ATI Xpress 3200 чипсете (1-й с полноценным Кроссфайром благодаря 40 PCIe линиям в севернике, делался ещё для X1800XT) работают все карты вплоть до HD48x0 включая HD4870 X2, но HD3870 X2 не стартует (то ли мост PLX кривой, то ли вся карта такая). HD5870 и прочие HD5xx0 не работают вообще, хотя некоторые HD5970 всё-таки работают (видимо, которые с обновлённой ревизией моста). HD69x0 работают все и с HD7970 тоже проблем не было. |

|

| Автор: | msivano [ 16:03 28.01.2015 ] |

| Заголовок сообщения: | |

DigiMakc Даже не смотря на это падение производительности чисто символическое. Мне что реально на состав накапать таких примеров? Легко — для начала на маленькую тележку — Скорость матриц меряют по переходу от серого к серому, а должны по нормальному мерить по реакции перехода цвета в цвет. Скорость инета указывают, как пример, 100 мегабит, а качаешь со скоростью 10, хотя платишь за 100 ( я знаю про то, что ответишь по этому поводу, не трудись) — я сторонник того чтобы в договорах указывалась та скорость, которая клиенту доходит и платить именно за нее. Покупаешь смарт с 16 гигами своей памяти, а доступно от силы 12, Скорость на винчестерах — сата 6гб/сек — в лучшем случае 600 метров в сек скорость обмена данными, скорость усб 3,0 в 5 гб в сек — от силы, в лучший день 340 — 420 удавалось достичь при копировании и записи с ссд по порту, хотя в компе честных 570 через сата есть, еще можно продолжать и продолжать. Короче маркетинг правит миром, а в мире реальность редко сходится с маркетингом. |

|

| Автор: | Katiphus [ 16:35 28.01.2015 ] |

| Заголовок сообщения: | |

msivano

Да только в случае с дисками там место изымается потому что туда записывается служебная информация, а в случае с 970 Хуанг нагло наврал — это раз, у видеокарт доступна вся память — это два.

Даже мой 290X, который вы обвиняете в том что именно он корень моих Блэк Скринов, так не умеет при просмотре флеш видео как на твиче так и на ютубе.

Ммм? Это интерфейс SATA у которого максимальная пропускная способность 6ГБ/с. Он не имеет отношения конкретно к скорости работы HDD/SSD дисков.

Ну это либо провайдер уродский что не в состоянии поддерживать скорость в вашем городе без перебоев, либо вы не в состоянии реализовать скорость вашего канала на всю. У меня получается нагружать каждый день свой канал на все 80Мбит/с.

А операционной системе где располагаться? Считай ситуация как с жесткими дисками.

Маркетинг маркетингом, но вы же не бежите покупать компьютер из эльдорадо потому что в рекламе сказали 2 ядра 2 гига игровая видеокарта? А все почему, а потому что стоит поставить ряд вопросов: что за процессор? что за память? что за игровая видеокарта такая? какая фактическая мощность системы и ее стоимость? после ответа на эти вопросы и рационального вывода вы уже решаете покупать или нет. Тоже самое и здесь SATA это всего-лишь интерфейс, с дисков всегда съедалась часть пространства, скорость интернета всегда зависила от тарифного плана а не от появляющегося снизу справа окошечка в котором написано >подключение к сети на скорости 100Мбит. И опять же в случае с GTX970 был не маркетинг а ложь. Разные вещи совершенно. |

|

| Автор: | msivano [ 16:41 28.01.2015 ] |

| Заголовок сообщения: | |

Katiphus В случае с дисками там место изымается потому, что по краям блинов очень велик риск иметь бэды, от того и обрезают програмно по кусочку. В случае с флешками потому, что нужны ячейки под перезапись отработавших свое ячеек. Везет что не умеет, но я по мойму и не утверждал что проблема поголовная, я лишь отметил что достаточно распространенная. Не приписывайте мне того , чего я не писал. Ты не понял, юзаешь ты канал свой на 80 мегабит, но скорость скачки то всего 8 ( простая математика 80 делим на 10 ) — то есть эффективно имеем десятую часть, и я сторонник того чтобы это оговариловась контракте. Пример — иду к провайдеру и беру тариф в 10 мегабит — прихожу и качаю со скоростью в 10 мегабит. А провайдер у нас и на самом деле уродский, оптику ложит по окраине, а мой дом от их головного офиса и датацентра в пардон километре с небольшим, и щиток стоит — бери да прокладывай. Ответ один — нет технической возможности, ожидайте очереди, причем очередь эта не известно когда. Вот за 4 года подключили 300 тыс абонентов по оптике, но а за этот год планируют еще 255 тыс, причем оборудование убого дают ( бывал у них в сц — стоит в мешках из под картошки, китайское говно ) нормальное не купить. Телефон работает только пока включен воип шлюз, выключи или свет пропади и привет каменный век. Альтернативы нет. |

|

| Автор: | Katiphus [ 16:54 28.01.2015 ] |

| Заголовок сообщения: | |

msivano

Или вы не поняли. В тарифном плане указывается скорость в мегаБИТах — и это важно, потому что большинство приложений указывают скорость при скачивании в мегаБАЙТах. По этому качая на скорости в 80Мбит/с я могу получить на выходу 80/8=10МБ/с И еще Мб и МБ — разные обозначения.

Это не важно будет ли длинна кабеля от сервера до вас 10 метров или 1км ибо скорость света. Разница будет разве что в 0.01мс которую вы не заметите никак. |

|

| Автор: | msivano [ 16:57 28.01.2015 ] |

| Заголовок сообщения: | |

Katiphus Нет не поняли именно вы. Скорость скачки и соединения меряется в мегабитах. Это место рапределяется в мегабайтах. Учите матчасть. -- Добавлено спустя 1 мин 47 с -- Katiphus Важно, если до сих пор прихоодится сидеть на АДСЛ |

|

| Автор: | Katiphus [ 17:00 28.01.2015 ] |

| Заголовок сообщения: | |

msivano Я достаточно осведомлен в плане сетей. И то что я прочитал выше для меня свидетельствует о том что либо вы не шарите, либо не правильно формируете мысль. |

|

| Автор: | msivano [ 17:00 28.01.2015 ] |

| Заголовок сообщения: | |

Katiphus Не смеши мои тапки. 1 мегабит эффективной скорости скачки способен давать мегабайт получаемой информации в секунду, так как скорость скачки будет равно 1024 килобитам, что равно 1 мегабайту . При скорости в 100 мегабит мы имеем 10 мегабит активной скачки, и получает 10 метров в секунду ( показатели усреденены ), это значит что на получение одно гигабайта информации у нас уйдет около 10 минут в среднем. Учите специфику протокола обмена данными, спецура... То что тебе спид тест намерял это лишь ширина канала, но эффективная его часть всегда в среднем делится на 10. Иссправить эту ситуацию обещают в скором будущем, так как был разработан новый алгоритм компресии/декомпресии служебной информации, которая используется для установления связи между абонентами, что обещает поднять эффективную часть канала до 5 раз, то есть теперь при 100 мегабитах мы реально будем иметь скачку равную 50 мегабит и получать по 50 мегабайт информации в секунду. Минус усовершенствования протокола лишь в одном — пока его теоритически полезная длинна не может привысить 10 километров. |

|

| Автор: | Katiphus [ 17:03 28.01.2015 ] |

| Заголовок сообщения: | |

msivano А что не так? Вы пишете >Скорость скачки и соединения меряется в мегабитах. — Хорошо, я правильно понимаю что при 80Мбит/с по тарифному плану я имею право качать со скорость 80Мбит/с файлы из интернета? В таком случае если перевести 80Мбит/с в Мегабайты (80/8=10Мегабайт/с) то получается что я качаю может не 10 (такое действительно редко бывает), но 9МБ/с у меня набирает 100% И да, как я могу смешить ваши тапки если вы получаете Байты деля Биты на 10, а не на 8. Сами бы не позорились.:( |

|

| Автор: | msivano [ 17:12 28.01.2015 ] |

| Заголовок сообщения: | |

Katiphus я усредняю показатель, так как параметры сети редко бывают идеальными. По этому поводу есть анекдот: Молодой программист знает что в мегабайте 1000 килобайт, но уже начинает в этом сомневаться. Опытный программист знает что в мегабайте 1024 килобайта, и потому абсолютно спокоен. пойду пока почитаю ману про дебиан 7.8 — а вы пишите, если что, отвечу позже. |

|

| Автор: | Katiphus [ 17:23 28.01.2015 ] |

| Заголовок сообщения: | |

Я все равно не понимаю о чем речь. Почему при 100 мы будем иметь лишь 50? Почему при скачке 50Мбит/с мы будем получать 50МБ/с (больше чем имеем) если 50Мбит/с =/= 50МБ/с. Как вы вообще собираете получать БОЛЬШЕ информации при МЕНЬШЕМ значении скорости? |

|

| Автор: | msivano [ 17:26 28.01.2015 ] |

| Заголовок сообщения: | |

Katiphus Потому, что служебная информация, которая занимает 90% кана связи будет сжиматся более эфективно, что позволит поднять реально входящую скорость почти в 5 раз, то есть вы к примеру будете не 9 метров получать, а 45, при той же скорости подключения. Это позволит разгрузить и без того перегруженные магистрали оптволоконной связи. |

|

| Автор: | Katiphus [ 17:30 28.01.2015 ] |

| Заголовок сообщения: | |

msivano А случайно не будет проблемы с задержкой? Одно дело передать информацию весом пару килобайт, а другое дело передать пару килобайт и декодировать в мегабайт. |

|

| Автор: | msivano [ 17:35 28.01.2015 ] |

| Заголовок сообщения: | |

Katiphus Не будет. Пока информация кране скудная, но проект финансирует гугл и какой то там институт ( проскакивало в инете ), прикол в том что не трнебуется нового оборудования, лишь обновляются спецификации протокола, но тестовые испытания показали что при существующих 100 мегабитах можно комфортно смотреть 4к видео без пережатия, но исследования носят полузакрытый характер. Пока решают вопрос увеличения длинны кабеля. Началось все с проекта Zopfli, пару лет назад. |

|

| Автор: | DigiMakc [ 17:41 28.01.2015 ] |

| Заголовок сообщения: | |

Серый — это совкокупность цветов. Какая разница какой цвет? У меня в договоре тарифный план Альфа серии бесконечность, когда я его заключал то скорость была 0,1 Мбит/сек, сейчас честно говорят: "до 55 мбит/сек" и ещё платить теперь не 600 руб, а 500. Причём эти 55 Мбит/сек не какие-то мифические, а реальные, юторрент качает 6 с лишним МБайт/сек. Потому, что часть занимает ОС. Производитель не говорит, что они свободны и не говорит, что они заняты. Сата 6 гб/с — это скорость канала которым соединяется хард с мамкой, а не скорость работы харда. Тоже самое и к ЮСБ относится. Это Вы не поняли. Скорость канала/подключения указывается в Битах, а скорость закачки — в байтах. Что за бред? Уж простите. 1 Мбайт = 8 Мбит, чтобы получать 1 МБайт/сек, надо чтоб скорость была 8 Мбит/сек. А 1 Мбит/сек даст всего 0.125 МБайт/сек.

При скорости 100 Мбит мы имеет 100 Мбит, = 12.5 МБайт/сек. Что бы скачать 1 Гбайт надо 1024/12,5 = 81 сек Ну пусть в реале будет не 12,5, а 10 МБайт/сек. Итого скачается не за 81 сек, а за 102 сек. Почитайте лучше про биты и байты  Вот это жесть... Кто же Вам такую чушь в мозг загрузил? -- Добавлено спустя 3 мин 7 с -- Katiphus Фильтруйте то, что пишет msivano, там половина информации забита "каким-то служебным трафиком" далёкого от реального положения дел

|

|

| Автор: | msivano [ 17:48 28.01.2015 ] |

| Заголовок сообщения: | |

DigiMakc Серый к серому, номы ведь не серое на нем смотрим. Как минимум цветное что то. А я и не говорил что скорость винчестера 6 гиг в секунду, я указал что скорость порта, такая, а скорость обмена данными достигает гдет о 600 мегабайт в секунду при копировании с ссд на ссд, в моем случае. Ну со временем малость обсчитался — у меня ж адсл, по себе мерил. Мне оптику с 100 или хаб аналогичный проложат еще фиг знает когда — страдаем  -- Добавлено спустя 2 мин 59 с -- DigiMakc Ищите инфу о проекте Zopfli. Это только основа, которую применяют для разработки новой версии протокола. |

|

| Автор: | DigiMakc [ 17:55 28.01.2015 ] |

| Заголовок сообщения: | |

msivano Ещё раз. Серый — это совокупность красный+зелёный+синий. Если иметь какой-то другой цвет в виду, то меняется лишь соотношения яркости красного, зелёного и синего. Любой цвет — это соотношение яркости красного, зелёного и синего. Ну а к чему Вы тогда про скорость порта заговорили?) 600 МБайт/сек с SSD на SSD — это очень даже норм. Производители примерно такую скорость и заявляют. Ну удачи Вам в решении проблем со скоростью инета. |

|

| Автор: | msivano [ 18:11 28.01.2015 ] |

| Заголовок сообщения: | |

DigiMakc К тому говорил, что потребители в основном ведутся на цифру 6гб в сек и думают что это вень с такой скоростью работает. Как пример возьмите коробку от материнки — правда красивая — какие цифры и показатели, только вот большинство глядя на них понимают под ними не то что нужно знать и понимать. Сколько раз говорил, что в сата 6 можно ткнуть сата 3 и сата 2 вень , и если вень нормальный то разницы не увидишь. Касательно Матрицы скажу проще — пользуясь тем, что нет единого приказного стандарта измерений, они меряют как хотят. В основном по скорости перехода от серого к серому. Некоторые указывают скорость реакции матрицы. Как пример — 14мсGtoG/7мс. Или в телевизорах количество герц 100 — 200 — 400 — 800 — 1000 и приходится им объяснять что это не развертки частота, а так называемая скорость регенерации, то бишь восстановления состояния пикселя к исходному, что позволяет смотреть очень динамичные сцены с максимальной детализированностью в мелких деталях ( по сути видишь много мелочи, которая просто смазывается на медленных матрицах), но при этом свое аналоговое они как видели в 50 герц так и будут видеть. От того вот такие маркетинговые уловки расчитаные на лохов и позволяют вводить в заблуждение. |

|

| Автор: | Katiphus [ 18:11 28.01.2015 ] |

| Заголовок сообщения: | |

msivano

Раскрою один секрет но кодек H.265 уже позволяет на текущем интернете средней скоростью 30Мбит/с смотреть без труда 4к.

Оптоволокно может быть любой длины. Дальше 100 метрами витой пары можно что угодно подключить. Не вижу проблем. |

|

| Автор: | msivano [ 18:18 28.01.2015 ] |

| Заголовок сообщения: | |

Katiphus Это я и так знаю, сам занимаюсь бетатестом этого кодека — исходники в сети лежат свободно. Пока тестируем конвертер на его основе и дорабатываем алгоритм компрессии. Рекорд 35 гиговый непержатый бд дик ужался до 565 метров с качеством картинки на уровне 7 гиговых торрентовских рипов. Минус только один — считает пока только процессором при перекодировании, ну и малость его нагружает при воспроизведении. Но это так любительское баловство. Ну ивремя ну очень много надо. На работу ушло 32 часа почти. -- Добавлено спустя 4 мин 57 с -- Katiphus Волокно да, но его еще хотят и для лановской сети тоже, чтобы обмен данными в датацентрах тек быстре, а агоритм компресии пока не совершенен — очень времязатратен. Гугл для начала его в смартфоны хочет пустить, дабы расход мобильного трафика уменьшить. Конвертер называется Hybrid, можешь по тестировать на досуге. Для оптики и так за последние несколько лет переписывали алгоритмы работы, что очень прилично смогли повысит скорость передачи данных, а наш провайдер ( сцуко он эдакий ) абонету дает оборудование совместимое шестой версией протокола, а в цод покупал оборудование рассчитанное только на 4 версию протокола. Как итог теперь закупает новое. Про потерю пакетов вообще молчу, иной раз у отдельных абонентов доходило до 38%, при том что уже при 3% сеть мертвая. У всех в нормальных странах в договоре пишут скорость от, а у нас до. А до это ведь понятие растяжимое  , случись что и фиг чего добъешься. , случись что и фиг чего добъешься.

|

|

| Автор: | DigiMakc [ 18:54 28.01.2015 ] |

| Заголовок сообщения: | |

Кто ведётся? В первый раз слышу. Да и какая разница... Призводитель указывает скорость работы порта, а не скорость работы устройства. Если потребитель не шарит нифига, то причём тут производитель? Производитель в данном случае никого не обманул. Это не просто частота регенерации. Сама по себе высокая частота картинку не сгладит. Там стоит специальный "блок", который "делает средние кадры" между основными, этим самым сглаживая картинку. А так же, высокая частота нужна для для более качественного 3D, и расширения функционала 3D. Но то, что пользователь понимает под этим что-то другое — опять же не вина производителя. Вот враньё производителя было, например когда Samsung писал что LED телевизор. В то время, как это ЖК с LED подсветкой. И в своё время по этому поводу тоже была некоторая шумиха. |

|

| Автор: | msivano [ 19:05 28.01.2015 ] |

| Заголовок сообщения: | |

DigiMakc Заедите к нам, покажу много таких олухов. Касательно опорных кадров я знаю. Я и не говорю что производитель обманывает, я как раз говорю про невнимательность при понимании написанного. Это как в старой поговорке, ты мне так сказал, что я тебя так понял  Я просто привык выражаться при общении простым, абстрактным языком, потому меня трудно понять иногда. Который день копаю линеводческие форумы. Хоть бы одна сволочь толково объяснила как примонтировать несколько веней к одному месту HOME. В винде подобное можно символическими ссылками оформить, но там  Так зашел в домашнюю папку — а там папка видео, под нее один вень — музыка другой — документы и всякое — третий. А так просто объясняют как примонтировать к точке, но при этом такое решение жутко неудобно выглядит. Так зашел в домашнюю папку — а там папка видео, под нее один вень — музыка другой — документы и всякое — третий. А так просто объясняют как примонтировать к точке, но при этом такое решение жутко неудобно выглядит.

|

|

| Автор: | DigiMakc [ 19:58 28.01.2015 ] |

| Заголовок сообщения: | |

msivano Но касательно данной темы, говоря о GXT 970, производитель не просто скрыл какие-то особенности, но ещё и обманул

|

|

| Автор: | msivano [ 20:02 28.01.2015 ] |

| Заголовок сообщения: | |

DigiMakc Я этого и не отрицал, читай на первой странице мой пост касательно — Что имеем в сухом остатке. Я писал что не обманул в количестве памяти, которая доступна. Скорее всего это толкнет нв сбросить цены. И да подтверждено официально — 12 директ доступен всем картам с поддержкой 11, 11.1 директа, правда ни одна контора полной поддержки не получит, но обещают что сильно это не скажется, так как все основное будет доступно и работать. |

|

| Автор: | Walter S. Farrell [ 21:01 28.01.2015 ] |

| Заголовок сообщения: | Re: |

Это что за служебная информация, на которую уходит 90% полосы канала? Заголовки IP — пустяк для проводных сетей, 60 байт максимум на пакет, обычно 20 байт. QoS может отожрать, допустим, 10%. Fast Ethernet, который 100МБит/с, на кроссовом соединении или через один быстрый свич (магазинный ширпотреб идёт мимо) пропускает до 9,1МБ/с полезной информации по FTP. Это 9,1 / 12,5 = 73%. Чем больше сеть, тем хуже масштабируется Ethernet, впрочем, у магистральных провайдеров другие игрушки, но чтоб 90% полосы потерять в исправной сети, это перебор. |

|

| Автор: | SrID [ 21:21 28.01.2015 ] |

| Заголовок сообщения: | Re: |

Чего-чего-чего ты хочешь? Я ничего не понял... Нарисуй. |

|

| Автор: | msivano [ 21:24 28.01.2015 ] |

| Заголовок сообщения: | |

Walter S. Farrell Скажите это наШему провайдеру, будь он не ладен. Поскольку сами мы трафик почти не производим, мы его покупаем и перепродаем. И дошло до того , мощности цода распроданы всем поставщикам интернета у нас в стране. То есть по сути, при большом количестве провайдеров, трафик все равно идет через белтелеком. А в добавок, чтобы было совсем хорошо в каждом роутере зашито 2 точки бесроводного доступа, одна из которых общественная и не удаляемая никак, даже под рутом через телнет. Мало того еще и услуги айп тв + домашний телефон за счет воип, а тот шлюз, который дают абоненту говно, а аналогов не достать. Вот и получается — имеется H208N воип шлюз, который юзают и как роутер, и как публичную точку доступа, и как воип телефонию, и как передатчик иптв на приставку к тв, и все это через обычную медь в моем случае, причем юзается одновременно. -- Добавлено спустя 4 мин 8 с -- SrID Хочу следующее — Как мы знаем у линя есть такая домашняя папка пользователя, где ему рекомендуется по умолчанию хранить свои докуметы, видео, музыку. В случае когда один винчестер проблем никаких. Но я хочу на каждую папку подмонтировать отдельный винчестер. Получится что войдя в своей домашней папке в подпаку видео, музыка, документы, я получу доступ сразу на отдельный раздел, закрепленный за каждой папкой. Именно в таком виде хочу получить результат. |

|

| Автор: | SrID [ 21:31 28.01.2015 ] |

| Заголовок сообщения: | |

msivano Тогда еще два вопроса: сколько у тебя пользователей, и в чем заключались методы, которые тебя не устраивали? |

|

| Автор: | msivano [ 21:34 28.01.2015 ] |

| Заголовок сообщения: | |

SrID Один — я. Не устраивает тем, что конкретно на папку по умолчанию не монтируется, но вот создай папку отдельно, тогда. Но вот при этом открыть права доступа к папке не дает. Получается — папку вижу, а пользоваться не могу. С каталогами в NTFS такой фигни нет, только с ext4. В винде это реализовать можно символической ссылкой на каталог. Это бы позволяло в случае переустановки системы просто перемонтировать каждый вень на свой каталог обратно и пользоваться как привык. |

|

| Автор: | SrID [ 21:48 28.01.2015 ] |

| Заголовок сообщения: | |

msivano А что за папка по-умолчанию? Не монтируется в не пустые папки (как и в windows), если эта какая-то хитрая папка с особым значком, то внутри может быть скрытый файл, проверь. То, что прав на запись нету, это от настоек файловой системы зависит. Попробуй по рутом права проверить когда файловая система смонтирована, возможно там root:root на корене фс установлено. |

|

| Автор: | msivano [ 21:55 28.01.2015 ] |

| Заголовок сообщения: | |

SrID Папка по умолчанию это точка монтрования каталога хоум, а в ней система автоматом создает поддиректории для документов и файлов пользователя по умолчанию. Аналог папки мои документы в винде. Пробывал под рутом проверять, да дествительно такое установлено. Права я на запись получал, но желаемого результата это не дало. Эти стандартные методы я испробывал сразу — не подходит. Файловая система лочится и все, хотя пишет что права получены, но стоит туда что либо записать попробывать, или каталог создать, то от ворот поворот. В случае когда винчестер только один такая проблема отсутствует. |

|

| Автор: | DigiMakc [ 22:11 28.01.2015 ] |

| Заголовок сообщения: | |

Ну не знаю как по FTP, а по обычной домашней LAN и больше даёт. А если вручную на сетевухах 100 МБит/сек полный дуплекс поставить, то в совокупной скорости приём+отдача вообще красота. Но мне пофиг, у меня гигабитный роутер

|

|

| Автор: | SrID [ 22:25 28.01.2015 ] |

| Заголовок сообщения: | |

msivano Ошибка именно permission denied или какая-то другая? Не могу повторить. Смонтировал, сделал "chown -R srid:users folder && chmod -R u+rwx folder" и все заработало. Как именно смонтирована хоум? Обычно отдельно выносят сам /home, но я так понял у тебя на отдельном разделе /home/${USER}? |

|

| Автор: | msivano [ 22:29 28.01.2015 ] |

| Заголовок сообщения: | |

-- Добавлено спустя 4 мин 55 с -- SrID Основной диск разбит стандартно — / и /home — своп отсутствует так как памяти 16 гиг оперативной — и вот папкам в этой /home я пытался за монтировать по венику — отдельно на папку видео , отдельно на папку музыка, отдельно на папку документы |

|

| Автор: | SrID [ 22:50 28.01.2015 ] |

| Заголовок сообщения: | |

msivano Короче, у меня получилось. Не понимаю, почему не получилось у тебя. Сделал так: сначала от рута смонтировал диск в желаемую папку, условно назовем ее /home/user/Video. У меня это были обычные папки без всяких хитростей, но это может зависеть от оболочки, которая создавала профиль. У новеньких, только что созданных фс права на корень всегда стоят root:root, по этому под пользователем, конечно ничего не записывалось. Чтобы это исправить, я от рута выполнил "chown -R user:users /home/user/Video", после чего пользователь user стал владельцем всех файлов на фс, смонтированной в /home/user/Video. После этого все работало, даже если размонтировать и смонтировать диск заново. Можно добавлять запись в /etc/fstab. |

|

| Автор: | msivano [ 12:20 29.01.2015 ] |

| Заголовок сообщения: | |

SrID Будет время попробую так. -- Добавлено спустя 3 ч 41 мин 34 с -- Касательно проблемы 970 — нв вроде бы сказала, что в ближайшем релизе дров несколько выправит ситуацию с адресацией и скоростью работы памяти карты, а так же повысит немного общую производительность. |

|

| Автор: | SevenXP [ 00:42 30.01.2015 ] |

| Заголовок сообщения: | |

msivano Понимаешь они сделали GTX970 специально с дифектом. И в пихнули 512 мб памяти, которая этой видеокарте выходит что и даром не нужна. А ты за это платишь. А доказывать тут нечего, NVIDIA уже все подтвердила. + Сам факт, что они знали о косяки и пока не тыкнули их, они драйверами получается, занижают мощность GPU. По тому что пишут, что мы добавим вам FPS. Ну и разве это нормально? Про цены ваши не знаю у нас в среднем от 400$ GTX 970 а GTX980 от 600$ понятно что от Palit. + Мне даже не нравится что у GTX 980 всего 4гб, по тому что у меня уже 2-ве игры в этом году, съели все 4 гб ОЗУ. А с новой Фичей DSR будет куда больше игр. Да и большинство игр подтягиваются к 3 гб и запас в 512 мб меня не устраивает. И еще момент GTX 970 проигрывает GTX 980 примерно 15-25% в среднем 20% в нагрузки до 3.5 гб. А когда загрузка больше 3.5гб ( предположительно, помню игры, большое разрешение) и разница доходит до 30%+ А это уже серьезно. (То откуда я выводы делаю, смотрел стандартную карту от NVIDIA 970 vs 980 2-ве GPU стандарт без разгона) И по мне 30% это не слабо. + Очень интересно стало, недавно увидел, что сейчас видеокарты не полностью поддерживают DirectX и надо аппаратная поддержка. Встал вопрос поддерживает ли 900 серия все API DirectX 12. По тому что я хочу взять GPU на 2-3 года и этот момент уже важен. Как и про память на 512мб |

|

| Автор: | Asmodeus [ 01:10 30.01.2015 ] |

| Заголовок сообщения: | |

NVIDIA пока не готова к массовому возврату видеокарт GeForce GTX 970  AMD намекает, что у её видеокарт работают "все четыре" гигабайта памяти  "Скандалы, интриги, расследования"@

|

|

| Автор: | DigiMakc [ 01:18 30.01.2015 ] |

| Заголовок сообщения: | |

Хороший урок для производителей

|

|

| Автор: | Inversion [ 04:24 30.01.2015 ] |

| Заголовок сообщения: | |

нвидия всегда разводила на далары. тут следует какой вывод — дело не в нвидии, а... |

|

| Автор: | msivano [ 06:46 30.01.2015 ] |

| Заголовок сообщения: | |

SevenXP Тут ты не до конца прав. Все производители занижают производительность карт, амд не исключение ни разу. Затем постепенно код дров отлаживают и производительность по тиху растет. Это нормально, так как движков игровых не один два, да и не только играми приходится заниматься картам. Касательно разницы в производительности ты опять не прав до конца, сравни техническую часть, прежде чем включать эмоции — 970 — 104 текстурных блока + 56 блоков растеризации, в то время как у 980 — 128 текстурных блоков и 64 блока растеризации. От сюда в основном разница и растет, а не от количества только лишь памяти. Как пример у моей карты 32 текстурных блока и 128 блоков растеризации.Чем больше этих блоков, тем лучше. Если бы у 970 было все 64 текстурных блока, то она сливала бы 980 только в высоких разрешениях, а тогда и смысла выпускать 980 не было бы, а так 970 находиться там, где и надо по ценовому фактору и по производительности. А все фичи 12 директа не доступны и текущим амд тоже, держат его карты как и нв софтово, причем новые аппаратно от части, а старые карты только софтово. Так что у амд еще есть время на добавления всех инструкций директа, если подождет финальной десятки, а значит задержит выпуск карт до осени. А пока еще игры получат патчи, пока новые проекты выйдут, то карты с поддержкой 12 директа смысл брать появится только в 16 году. А касательно отъедаемой памяти играми, то если крутить настройки бездумно, в надежде на то что производитель идеально отполировал код игры в плане потребления ресурсов, а затем обвинять производителя железа что тебе не хватает памяти, чтобы в это играть, то это уже намек на неадекватность. Вы когда в игру играете, вы в игру играете? или пиписьками меряетесь, мол у меня не длиннее, пока я не упру все в потолок и у меня на моем корче не полетит все в облака... то будет короче? Я из этого возраста уже давно выжил. Сам был оверклокером со стажем, бегал за железом новым чуть ли не по 5 раз на год, гнал его, мерился попугаями, фпс, и прочей фигней, пока не заметил одну важнуюю вещь, которая приходит с возрастом и мозгами, если игра говно, то на каком бы ты железе ее не пытался запустить, говном она и останется. А вот если игра нормальная, и она меня заинтересовала, то я ее и при 30 фпс нормально пройду, и плакаться по этому поводу не стану — я играю в игру, а не игра играет мною. А касательно цен, я от вас всего в 200 км живу, цены у нас такие же + — 20 — 50 уе от ваших.8 И еще один маленький совет — если хотите карту с нормальной поддержкой 12 директа, исправлением всех косяков с его поддержкой и реализацией, то ждите 16 года. Именно в 16 году смысл брать карту есть, а пока копите на новую мат плату + ддр4 с высокой частотой памяти и цп на 8 нормальных ядер, которых вам хватит лет на 7 потом и 2 смены карт. |

|

| Автор: | Katiphus [ 07:32 30.01.2015 ] |

| Заголовок сообщения: | |

msivano

Dying Light сжирает на максималочках все 4ГБ, да и на минималочках тоже. Там от настроек мало что зависит. Вы только купили карту с расчетом на объемную VRAM, а ее уже можно выкидывать. |

|

| Автор: | msivano [ 07:44 30.01.2015 ] |

| Заголовок сообщения: | |

Katiphus Про что я чуть ниже и написал — код игры не отполирован, продукт сырой, но график на сдачу горит. Инвесторы уже ждут отдачу, а на проблемы игроков им на срать с высокой колокольни. Вот сейчас пойдут патчи, и глядишь через пол годика — годик, все заработает нормально. Первый раз что ли. И на последок, прежде чем бездумно, на эмоциях вырывать слова из контекста, прочтите все до конца пожалуйста, возможно там уже аргументировали свою позицию, чтобы не превращать флейм во флудильню

|

|

| Автор: | SevenXP [ 09:40 30.01.2015 ] |

| Заголовок сообщения: | |

msivano Вы о чем вообще. Мне до фени код. Я прихожу домой с новой игрой выставляю максимально качество и сглаживания FXAA и чаще всего у меня 40-45 fps. И мне хватает. Но как я уже написал. С таким FPS было уже 2-ве игры которые съели 4 гб. + От GTX980 я ожидаю, что выставлю полную максималку по сглаживанию. А это еще нагрузку на память. Опять же. Это вам по ходу надо отключить эмоции: 1) HD5000 вышла довольно быстро с DX11 и полная совместимость. Как минимум в играх 2) То что вы пишете а если да обы у GTX 970 было бы то то, то тогда бы цена была бы другая!!! Я говорю о том что, заведомо в архитектуре был косяк в GTX 970 не исключено, что он же на GTX 960. В течении полу года, NVIDIA положила болт и не чего не изменила и молчала в тряпочку. И по сути видеокарта нормально работает только с 3.5 гб. Так накой мне платить за 512 мб. Память для видеокарт достаточно дорогая. 1-гб в среднем 50-70$ если судить по ценникам. |

|

| Автор: | msivano [ 10:08 30.01.2015 ] |

| Заголовок сообщения: | |

SevenXP Вот по этому я и говорю что нужно отключать эмоции и включать мозг. Что вы походу и не собираетесь делать. Где я хоть словом обмолвился о HD5000. Изменить в архитектуре чипа ничего нельзя — она едина для всех карт разных ценовых категорий, в данном поколении.И не сама архитектура чипа тому виной, а то что изначально были выбраны чипы памяти не подходящей плотности и объема — 512 метровые банки в количестве 8 штук. Исправить это можно с легкостью, правда придется в новой ревизии карт использовать комбинированные чипы памяти либо чипы большей плотности ( выпустили их совсем недавно, и месяца еще не прошло ), то есть либо взять один чип на гиг и добавить к нему 6 чипов по пол гига, либо 4 чипа по гигу, что приведет к еще одному косяку, если посмотрите внимательно на рисунок ниже поста прикрепленный, то поймете что в случае номер два и номер один, придется отсекать лишние блоки растеризации + лишние блоки текстурирования + еще 256 килов кеша, либо добрую его половину, только потому что их не зачто будет зацепить. Другое дело, что второй вариант ( спасибо самсунгу ) стал доступен только считай сейчас, да и нельзя его применить , а первый вреда принесет больше чем сейчас ( в старых вариантах карт это уже проходили ) В итоге нв поступила единственно возможным способом на тот момент — дополнительные пол гига прикрутила вторым блоком. А вынужденны они были так поступить потому, что больше 8 чипов распаять на этой архитектуре нельзя, зато скоро выйдут 8 гиговые карты, лишенные этих недостатков,имеются в виду старшие модели, причем по вкусной цене, ведь новые чипы получились недорогими, — это уже тоже проходили пару раз, вспомним 2 варианта GTX260, 2 варианта GTX 560, да и амд с разными версиями ядра в одной серии карт, когда люди охотились именно за второй версией, а не перелицованной старой, покупали ведь кота в мешке и никто не жаловался. Я не пишу что если бы, да кабы — это вы пишете. Я констатирую факт, а именно почему 980 быстрее, чем 970. Я не говорю что нв поступила правильно, об этом можно прочитать на первой странице форума. Я сторонник того, чтобы она понесла наказание, и как минимум сбросила цены на 970 и прочие, если и там выявится дефект.

|

|

| Автор: | DigiMakc [ 17:33 30.01.2015 ] |

| Заголовок сообщения: | |

Тесты проблем с пропускной способностью памяти GeForce GTX 970 Неа, будет у GTX 970 7+1 Гб, с точно такой же проблемой как и сейчас. Сомневаюсь, что они будут перерабатывать ядро ГПУ. А дрова тут мало чем помогут Именно архитектура и является виной в данном случае. Это 2500 руб, на эти деньги можно неделю жить

|

|

| Автор: | SevenXP [ 18:13 30.01.2015 ] |

| Заголовок сообщения: | |

msivano Ты опять не понимаешь и лично я смотрю без всяких эмоций, что не скажешь по вам. Тем более у меня GTX 970 нету: 1) Факт что и за этого производительность ниже ( по сути она походу такая же, когда памяти и не хватает и лезет в ОЗУ) — есть такой шанс 2) Для этой архитектуре, выходит 512 мб как 5-тое колесо машине. 3) Я просто потребитель, меня не интересует как и почему, меня интересует за что я плачу. А по сути я плачу за высокую производительность на 3.5 гб но не за 4гб. + Меня в магазине об этих проблемах, не кто не предупредит и не предупреждал. А это на самом деле важный момент. Я как потребитель, если куплю себе этот товар. Я буду чувствовать что меня обманули. Я плачу за то, чего по сути и нету. За скорость работы памяти, которая описана в характеристике видеокарты, которая не выполняется, при загрузки памяти больше 3.5 гб. Это проблемы NVIDIA что ей тяжело делать более мощные GPU и по этому она режет. Что бы следующие GPU были более производительными и бежали покупать GPU. |

|

| Автор: | msivano [ 18:51 30.01.2015 ] |

| Заголовок сообщения: | |

DigiMakc Неа. 7 гигов памяти ей не вперлось, мало блоков растеризации, и еще меньше текстурирования — на фулке, ну и может 4 к этомогло бы от части помочь, но не поможет. А в 980 тоже профиту будет мало. Вот увеличь количество блоков в двое и дай ей столько памяти, то может свои 60 кадров в 8к, при не сильно высоких настройках и дало бы. А так архитектура не приделах. Чип способен дать возможность распаять 8 гиг, что вполне достаточно, и даже не сомневаюсь, что такие карты появятся, но толку будет маловато. SevenXP Тут проблема не в том что она не может, может она и следующее поколение ( на котором она сейчас и зациклилась ) тому доказательство. А 9 серию выпустили как тестовый вариант, подрядчики в добавок все никак не могут освоить 20 нм и потому сразу переходят на 16 ( че с них взять ), потому нв и исходило из того что было на тот момент. Зато мы увидели приличное снижение энергопотребления, что не может не радовать, что подвигло амд тоже ( наконец!!! ) спроектировать энергоэффективный чип, что не может не радовать, правда он еще официально не выпущен, но подождем. Не 512 мегабайт ей как пятое колесо, а то, что если распаять больше памяти и не отсечь еще 256 килов кеша + еще 8 блоков текстурированния + еще 16 блоков растеризации, то мы получим как раз то о чем упомянул выше и я и DigiMakc Тогда карта будет иметь свои 4 гига без проблем, но лишится еще части блоков. А если распаять всего 4 микрухи по гигу, то это уже 960 получитя, потому как еще приличней обрезать придется. Увы нв пошла по единственно логичному пути — распаять те злосчастных пол гига отдельным блоком и запараллелить его на соседний блок, отключив часть кеша, что в итоге дало нам приличный уровень производительности, с нормальным для 970 уровнем производительности, но вот потребителя предупредить забыла об от косяке, или не хотела, это уже пускай суд разбирается. Потребителю конечно осадок не приятный, но в целом карта работает вполне отлично — прошел у друга на ней фаркрай 4 — ни тормозов, ни лагов замечено не было. -- Добавлено спустя 6 мин 11 с -- DigiMakc Я имел в виду 980 серию, там это сделать можно, хотя блоков текстурирования маловато для такого объема памяти. |

|

| Автор: | Katiphus [ 21:22 30.01.2015 ] |

| Заголовок сообщения: | |

msivano

КОНТРАТАКУЮ!!1!11!

Источник: http://www.3dnews.ru/908856 Парировать будете?

|

|

| Автор: | msivano [ 21:41 30.01.2015 ] |

| Заголовок сообщения: | |

Katiphus Я ж говорил что это были слухи, или мне еще за слухи отвечать? — в ваших намеках нет логики — слухи были, они не подтвердились. Нв сама не отрицает того, что это были слухи, на фоне того что перехваченное сообщение было воспринято неверно. |

|

| Автор: | Katiphus [ 21:44 30.01.2015 ] |

| Заголовок сообщения: | |

msivano

Где? Не вижу что-то. |

|

| Автор: | msivano [ 21:45 30.01.2015 ] |

| Заголовок сообщения: | |

Katiphus А проследи выше тролль ушастый  -- Добавлено спустя 1 мин 20 с --

Взято было на том же ресурсе которым вы парируете.

В добавок нв не отрицает того, что подобное было распространено в сети. |

|

| Автор: | Katiphus [ 21:47 30.01.2015 ] |

| Заголовок сообщения: | |

msivano

Я прочитал все что вы написали начиная от Касательно проблемы 970 — нв сказала и до последнего, но не увидел даже намека про то что вы писали что это слух. Я даже пытался искать на странице слово >слух, но кроме как в последнем камменте после моего это слово больше нигде не встречается. |

|

| Автор: | msivano [ 21:52 30.01.2015 ] |

| Заголовок сообщения: | |

Katiphus Пока нет офф подтверждения с конкретным пруфом на заявление, которое было, но в последствии не подтвердилось, чем вы мне в лицо тычите, то отсутсвие слова — слух в цитате не опровергает тот факт, что заявление существовало. |

|

| Автор: | Katiphus [ 21:53 30.01.2015 ] |

| Заголовок сообщения: | |

Тем не менее вы им (этим заявлением) пытаетесь аргументировать свою точку зрения/использовать как довод/оправдание, хотя на мой взгляд это откровенное беливерство, а может даже и фанбойство по нВидии (освовываюсь на ваших рассказах по поводу GCN, BSOD'ов от Flash Player'а, и прочем нехорошем что АМД "не умеет делать"). Как там можно вообще фиксануть драйверами аппаратную проблему я даже не представляю. |

|

| Автор: | msivano [ 21:58 30.01.2015 ] |

| Заголовок сообщения: | |

Katiphus Вот оригинал, там как раз то, о чем я написал, и как раз то что нвидиа опровергла, но на тот момент это являлось неподтвержденной правдой, или слухом в сети, коим я и поделился. Но вы же тролль, цепляетесь к словам и извращаете сказанное, чем и служит доказательство якобы моей лжи, которое из Опроверженияна статью указанную сейчас мною и следует. А вот с чего вообще этот слух в сети родился, то самое перехваченное сообщение. Но я же вру, правда? и от фанбойства ( по вашей же версии ) скоренько сайты взломал и задним числом новость сварганил и пропечатал. |

|

| Автор: | Katiphus [ 22:16 30.01.2015 ] |

| Заголовок сообщения: | |

msivano Значит все что вы пишете является слухом и не подтвержденной правдой ибо не подкреплено никаким пруфом. Я умываю руки и ретируюсь.

Нет, вы сначала сообщаете о чем то, а потом прикрываетесь тем что это лишь слух. Хотя мне кажется что вам было очень удобно использовать информацию о драйверах на тот момент, потому что все были явно настроены отрицательно на GTX970 кроме вас, вы ее всячески оправдывали. |

|

| Автор: | msivano [ 22:20 30.01.2015 ] |

| Заголовок сообщения: | |

Katiphus В сообщении выше пруфы на все есть, а руки да, умывайте — гигена она нужна... И сетевые слухи публиковать никто не запрещает — новость есть, почему бы ей не поделится, вдруг оправдаются надежды, а если не оправдаются, то и фиг с ними — это интернет батенька. -- Добавлено спустя 5 мин 8 с -- Katiphus Я не оправдываю 970, а лишь описал причину для тех кто все же ее купил, по которой те 512 метров памяти так работают. А так же объяснил, для особо тугих на голову, почему исправленной 970 скорее всего не будет. Я и на первой странице не оправдывал, и на второй, и на третьей. На каждой есть мое порицание сей проблемы, а так же возможного пути разрешения оной со стороны нв, которое скорее всего выльется в снижение цены на карту и новой ревизии ее с исправленными обозначениями. И да для особо слепых: Страница 1

Страница 2 — отсыл на страницу 1 Страница 3

Только на третьей странице расписано все более подробною для тех кто схематический рисунок не понимает, который вставлен ниже поста. Что бы те кто купил, себе карту имели наглядное представление проблемы. |

|

| Автор: | DigiMakc [ 23:53 30.01.2015 ] |

| Заголовок сообщения: | |

msivano 7 Гигов ей как раз-таки впёрлось. Если учесть что уже сегодня 4 ГБ под завязку. Архитектура при делах, как раз из-за архитектуры у 970-ой проблемы. Не это подвигло АМД на разработку нового чипа  Не, я ничего такого не говорил, и не подразумевал. Вот ей просто нужно распаять гиговые модули, сделать карту 7+1, и тогда будет норм. (если не считать, что блоков и кэша меньше чем заявлено.) Нормально. |

|

| Автор: | msivano [ 00:19 31.01.2015 ] |

| Заголовок сообщения: | |

DigiMakc Ну хз, нафиг паять 7+1 и напороться на те же грабли. Если усечь еще на 256 килов кеш, то можно получить полно скоростную память без этого придатка. Но вот не отсечь еще блоки не выйдет. А вот для 980 8 гиг сойдет, но я остаюсь при своем мнении, хотябы количество блоков текстурирования нужно бы добавить на энное значение. Просто складывается впечатление, что когда чип обрезали под 970, то сделали это по принципу — авось прокатит. Как выяснилось не совсем прокатило, но и не все так плохо получилось. Не смотря на этот недостаток, карта в целом удалась, но цену нужно скидывать — объективно долларов на 50, а купившим карты до исправленной ревизии ( ну вероятной исправленной модели в плане описания и уточнения количества блоков, памяти и кеша ) предоставить по купону на игру в стим или ориджин. Ведь чтего греха таить, у нас сдать карты вряд ли получится, а так хоть какое то утешение.

Я имел в виду вот эти ваши слова. А ниже, ака и в этом посте, я повторил почему лучше так не делать. |

|

| Автор: | DigiMakc [ 00:45 31.01.2015 ] |

| Заголовок сообщения: | |

msivano Какие грабли? Сейчас проблема в том, что игрухи готовы грузить 4 ГБ памяти. А она у 970 "хитрая", лучше больше 3,5 ГБ не загружать. Если выпустить 8 ГБ 970, то будет по-сути 7 гиговая, и тогда памяти в игрушках будет хватать. Если же, как Вы говорите, усечь ещё кэша, то это только хуже сделает, да и проблему памяти всё равно не решит. Да прокатило бы, если бы они сразу об этом заявили, всё как есть бы рассказали. А так, получается обманули. |

|

| Автор: | msivano [ 01:03 31.01.2015 ] |

| Заголовок сообщения: | |

DigiMakc а эти 512 метров медленной памяти, к которым доступ вторичен по приоритету не грабли разве? Вот я и говорю что 7 гиговая 970 получится с полноскоростной памятью без одного гига тормозной памяти, но вот на слайд выше под одним из моих постов вы походу не смотрели, там ясно виден косяк, а так же как от него избавится в принципе можно, но пойти на это не пойдут. Потому что тогда не за что будет зацепить часть кеша и часть блоков растеризации и тексурирования не к чему будет привязать, получится что нужно или грабли делать повторно, чтобы их сохранить, либо этого не делать, оставив только полноскоростную память, припаяв вместо 8 банков памяти 7. Хотя есть вариант распаять банки памяти разной емкости, чтобы в целом собрать нужное количество, но последнюю микруху паять максимально меньшего объема, чтобы на цен не сказывалась. |

|

| Автор: | Asmodeus [ 01:52 31.01.2015 ] |

| Заголовок сообщения: | |

Тесты проблем с пропускной способностью памяти GeForce GTX 970 (обновление) |

|

| Автор: | DigiMakc [ 06:36 31.01.2015 ] |

| Заголовок сообщения: | |

msivano Я видел все слайды, им уже несколько дней. Пусть лучше 7 гигов + 1 гиг костыль, чем 7 или 8 гигов но с ещё больше отключенными блоками. |

|

| Автор: | 76FX [ 08:57 31.01.2015 ] |

| Заголовок сообщения: | |

Asmodeus  Неплохо троллят . Неплохо троллят .

|

|

| Автор: | msivano [ 09:22 31.01.2015 ] |

| Заголовок сообщения: | |

DigiMakc Вот и я про то же, пусть лучше этот костыль из 512 метров будет, чем нежели его отсутствие. Так карта сохраняет полезное количество блоков текстурирования, который завязан с кешем, и приемлемое количество блоков растеризации. А не лишив карты этих злосчастных 256 килов кеша, то у нее было бы все 64 блока текстурирования, благо блоки растеризации можно отключать без таких последствий, но это была бы уже 980 с которая проигрывала бы полноценной 980 только в высоких разрешениях, стоила бы она соответствующе. Хотя за умолчание подобных фактов, нв должна понести наказание и ответить как говорится долларом. -- Добавлено спустя 43 мин 26 с -- Немного не в тему, но ЭТО просто отличная новость. Это тоже радует, если подтвердится. Походу повторяется То самое, через что в свое время прошла нв. Дай бог, чтобы это было не так. |

|

| Автор: | Asmodeus [ 13:54 31.01.2015 ] |

| Заголовок сообщения: | |

Эту Лизу надо гнать из AMD по одному месту мешалкой....

|

|

| Автор: | msivano [ 14:03 31.01.2015 ] |

| Заголовок сообщения: | |

Asmodeus Тут не спорю, что то она не в ту степь компанию ведет... |

|

| Автор: | DigiMakc [ 14:11 31.01.2015 ] |

| Заголовок сообщения: | |

SHOCKING interview with Nvidia engineer about the 970 fiasco

|

|

| Автор: | Katiphus [ 14:40 31.01.2015 ] |

| Заголовок сообщения: | |

DigiMakc

|

|

| Автор: | Walter S. Farrell [ 14:58 31.01.2015 ] |

| Заголовок сообщения: | |

AMD мало что светит во встраиваемых решениях, там ARM окопался, даже MIPS вытеснил и Атом скоро подохнет (Mobile and Communications подразделение у Интела единственное убыточное). В серверных решениях Интел не подвинуть, а на одних камнях для приставок далеко не уедешь. Лучше бы дальше GPU и APU развивали, раз уж CPU загнали в тупик и все фабрики распродали. |

|

| Автор: | DigiMakc [ 15:10 31.01.2015 ] |

| Заголовок сообщения: | |

Walter S. Farrell Ну на серверные процы у Интел ценники серьёзные, АМД может по цена/производительность выгоднее. Вон в десктопе, бульдозер в некоторых задачах почти как i7, а ценник почти в 2 раза отличается. Думаю, что APU они не будут забрасывать. Они актуальны в ноутах. Для настольных систем слабоваты... А что фабрики.. Заказать проц не очень проблемно. Я считаю, что архитектура Бульдозер загнала в компанию в эту проблему. А упорное нежелание компании сойти с этого пути (пути бульдозеростроении) ещё больше усугубляет положение. Лучше бы K-10 свои и дальше пилили. |

|

| Автор: | Asmodeus [ 19:01 31.01.2015 ] |

| Заголовок сообщения: | |

| Автор: | SevenXP [ 20:26 31.01.2015 ] |

| Заголовок сообщения: | |

Кто слышал, когда там первый R9 300 начнут выходить? я слышал середина февраля? А издевательские видосы над NVIDIA прикалывают. -- Добавлено спустя 1 мин 43 с -- Кто слышал, когда там первый R9 300 начнут выходить? я слышал середина февраля? А издевательские видосы над NVIDIA прикалывают. msivano все больше и больше игр подбираются к отметке 4 gb. Еще пол года и все ААА игры будут забивать 4 гб. + DSR поможет в этом. |

|

| Автор: | Katiphus [ 21:48 31.01.2015 ] |

| Заголовок сообщения: | |

DigiMakc Уже и на русском есть. http://youtu.be/gWhuGkCEJAY |

|

| Автор: | DigiMakc [ 01:05 01.02.2015 ] |

| Заголовок сообщения: | |

Katiphus

|

|

| Автор: | Asmodeus [ 02:51 01.02.2015 ] |

| Заголовок сообщения: | |

Katiphus

|

|

| Автор: | msivano [ 10:34 01.02.2015 ] |

| Заголовок сообщения: | |

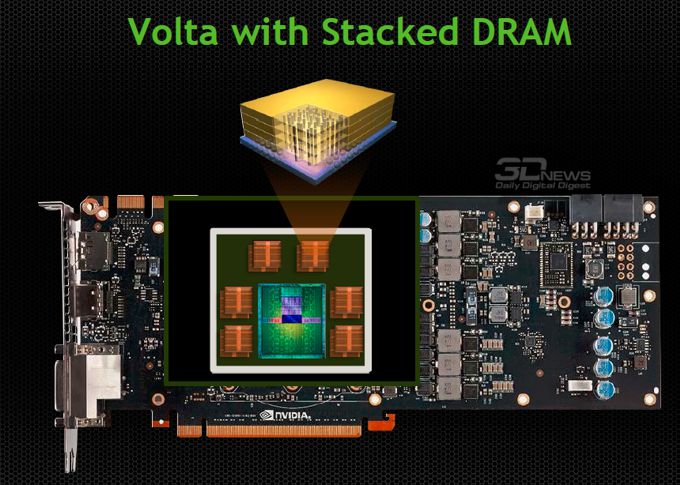

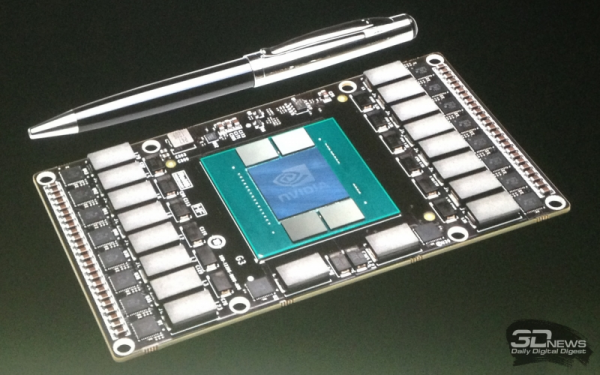

SevenXP Так это было ясно еще на старте новых консолей, там уже была видна тенденция. Вообще, из личного опыта, стараюсь брать карты чрез поколение от новых тенденций. Как пример — выходит GTX 4xx серии, намек в карте был виден сразу — минус один — горячие были, затем выходит 5хх и сразу видно что менять не стоит — это работа над ошибками. Зато 6хх серия уже была исправлением первых двух, хороший финальный продукт. Теперь 7хх + 9хх два варианта доработки, чтобы родить новое поколение карт для 4к — амд тут движется увереннее, но могут быть задержки в свете тяжелого финансового положения ( чипы для консолей и неумелое руководство тому причина, нв тоже через это прошла ), нв тоже движется в этом направлении, и тоже применит стековую память, но более интересно — чтобы избавится от бутылочного горлышка в виде шины обмена данными с ядром и памятью, они хотят распаять всю память непосредственно на подложке ядра, интегрировав ее прямо в ядро — получится или нет — увидим, но преимуществ у этого метода много — карты получатся компактнее, обмен данными будет происходить на скоростях в разы выше чем сейчас, производительность должна возрасти на первых этапах до 4 раз от текущей позиции. Так что обе компании попытаются удивить новыми картами, посмотрим что же у них выйдет в итоге. |

|

| Автор: | SevenXP [ 11:24 01.02.2015 ] |

| Заголовок сообщения: | |

msivano С AMD там другая фича на сколько я знаю. Они хотели выпустить GPU на 20нм и где то я читал, что они писали — Что слепки выходят очень плохого качества и годных к применению слишком мало. Вот там я и читал что 1-вые видеокарты должны выйти в конце февраля — март. + Там писали что возможно по 20 нм технологии будут R9 x390 а R9 x380 уже по 28 нм. |

|